Después de llevarme 2 días completos actualizando una Xubuntu desde la 9.4 hasta la 11.4 a base de descarga y actualización, descarga y actualización, … esta tarde me he puesto con el ¡RETROHARD MIDI!. Tengo un teclado MIDI antiguo de Creative, un Blasterkey, que venia en pack con una SoundBlaster AWE 32.

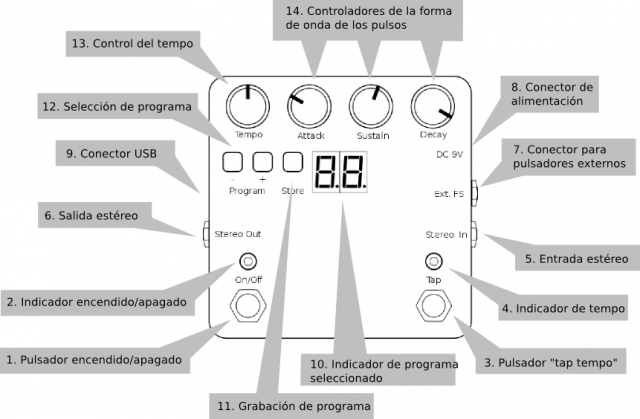

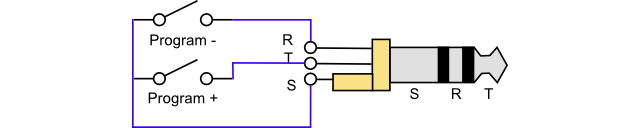

Se conecta al ordenador por el desaparecido y obsoleto puerto de juegos. Tiene un conector estándar MIDI OUT (DIM 5), así que se puede aprovechar. El problema es que su única fuente de alimentación es dicho conector. Antes de poner a modificarlo para añadirle la fuente quería probarlo con una tarjeta de sonido PCI con chip de Yamaha y el necesario puerto de juegos. De ahí que me haya pasado 3 días montando y actualizando una torre de PC desahuciada con una placa con un Atom 230, que se negaba a aceptar Windows XP, Windows 7 y Ubuntu 11.4. Solo he conseguido instalarle desde un pendrive una Xubuntu 9.4, y desde ahí el largo calvario hasta Xubuntu 11.4.

Con el sistema actualizado y con ALSA instalado, no tenía forma de ver el interfaz MIDI de la tarjeta. Después de mucho buscar en internet, la solución era añadir al fichero /etc/modprobe.d/alsa-base.conf la linea:

options snd-ymfpci mpu_port=0x330 fm_port=0x388 joystick_port=1

Y ejecute en un terminal

$ depmod -a

Comprobé que habia funcionado con

$ aplaymidi -l

Port Client name Port name

14:0 Midi Through Midi Through Port-0

16:0 Yamaha DS-1S (YMF744) Yamaha DS-1S (YMF744) MIDI

17:0 OPL3 FM synth OPL3 FM Port

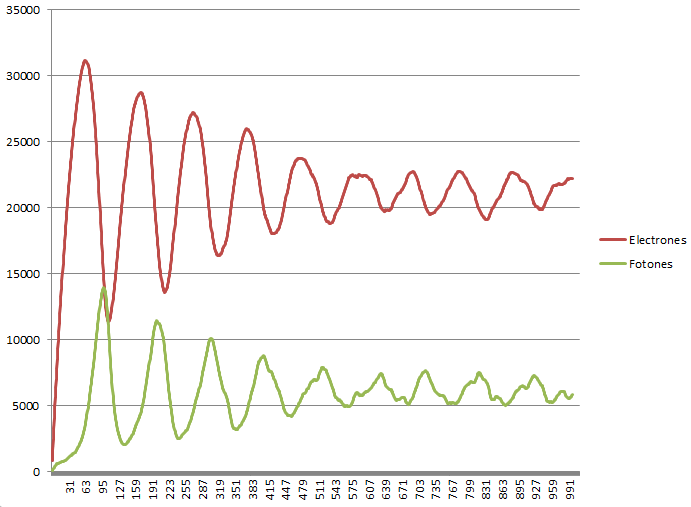

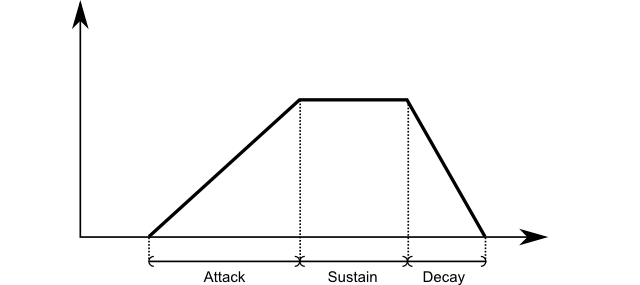

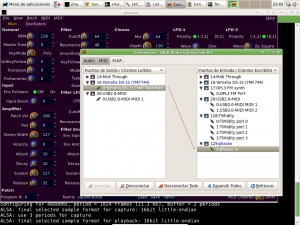

He hice alguna pruebas. Me ha llevado toda la tarde encontrar un programa interesante de simulacion de sintesis analogica: phasex. Hacerlo funcionar también ha tenido su trabajo pues me he tenido que instalar JACK, y para ello he tenido primero que saber de su existencia y entender su utilidad. Una vez lanzado el demonio correspondiente con:

$ jackd -d alsa

Desde QjackCtl he realizado las conexiones con cables virtuales y por fin me he puesto a jugar:

Debo dar mi agradecimiento al blog: http://www.josegdf.net/2009/01/sonido-en-ubuntu-studio.html, que me ha puesto en la pista correcta.